Video “How I use LLMs” của Andrej Karpathy thuộc series dành cho khán giả phổ thông về các mô hình ngôn ngữ lớn (LLMs) như ChatGPT. Tiếp nối video trước đã đi sâu vào các nguyên tắc cơ bản và cách tư duy về nhận thức của LLMs , video này tập trung vào các ứng dụng thực tế của những công cụ này. Trong video, Karpathy chia sẻ nhiều ví dụ cụ thể, giải thích các cài đặt khác nhau và trình bày cách ông sử dụng LLMs trong cuộc sống và công việc. Nội dung chính của Video gồm các mục như sau:

Giới thiệu chung về các Mô hình Ngôn ngữ Lớn (LLMs) như ChatGPT

ChatGPT, được phát triển bởi OpenAI và ra mắt vào năm 2022, đã mở ra một kỷ nguyên mới khi cho phép mọi người tương tác với các mô hình ngôn ngữ lớn thông qua giao diện văn bản. Sự kiện này đã lan rộng và trở thành một hiện tượng trên internet. Tuy nhiên, đến năm 2025, hệ sinh thái các ứng dụng tương tự ChatGPT đã phát triển mạnh mẽ và đa dạng hơn nhiều.

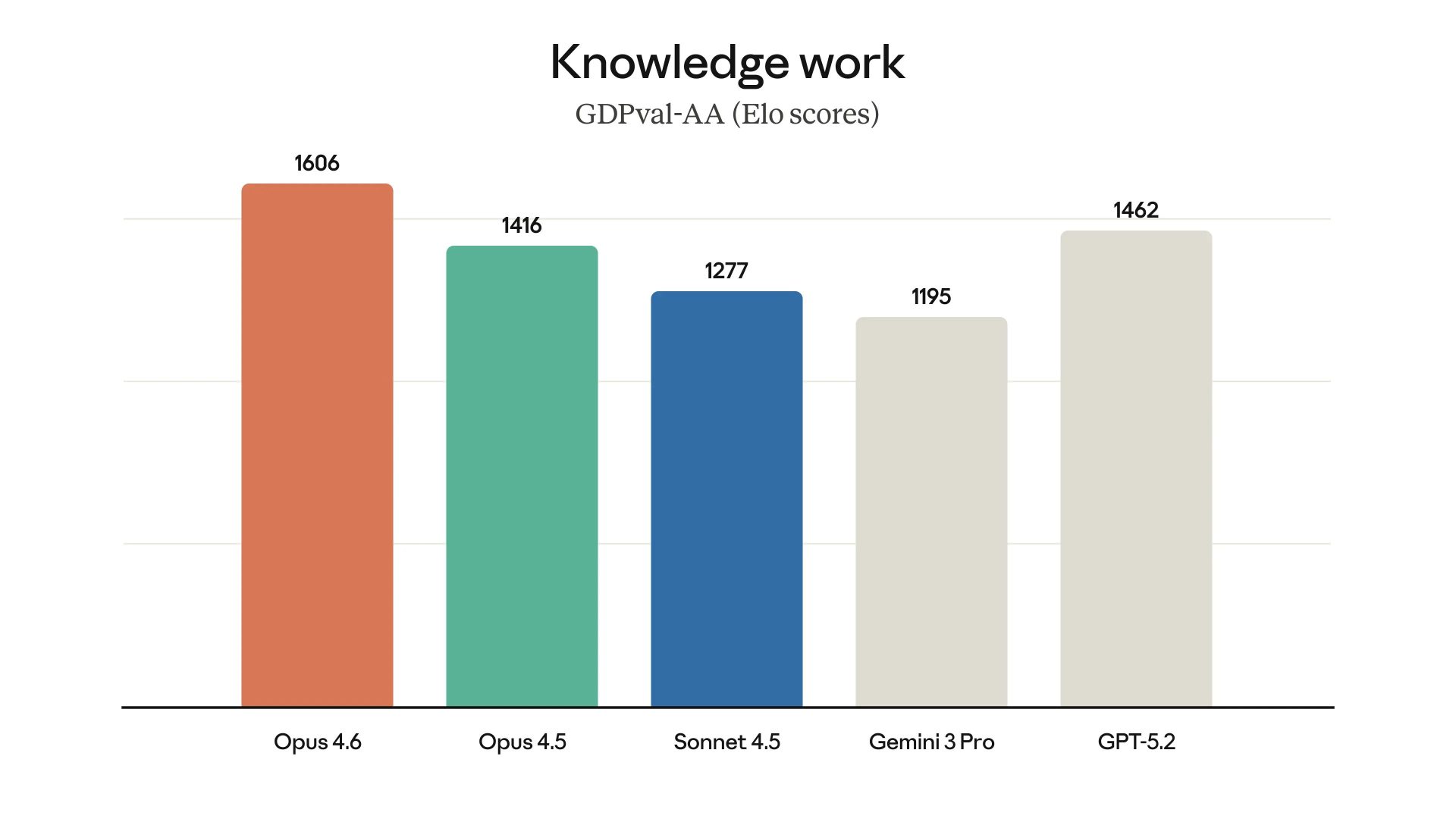

ChatGPT của OpenAI vẫn là một “gã khổng lồ” tiên phong, phổ biến nhất và giàu tính năng nhất nhờ thời gian phát triển dài hơn. Dù vậy, hiện nay có rất nhiều ứng dụng “ăn theo” với những trải nghiệm độc đáo riêng. Các tập đoàn công nghệ lớn như Google (với Gemini), Meta và Microsoft (với Co-pilot) cũng đã tham gia vào thị trường này. Bên cạnh đó, các công ty khởi nghiệp như Anthropic (với Claude), xAI (của Elon Musk với Grok), DeepSeek (Trung Quốc), LightChat và Mistral (Pháp) cũng mang đến những lựa chọn đáng chú ý. Người dùng có thể theo dõi sự phát triển và xếp hạng của các mô hình này thông qua các bảng xếp hạng như Chatbot Arena và SEAL Leaderboard của Scale.

Tương tác cơ bản với LLMs: Văn bản và Tokens

Hình thức tương tác cơ bản nhất với mô hình ngôn ngữ là gửi văn bản và nhận lại văn bản. Ví dụ, bạn có thể yêu cầu một bài thơ haiku về trải nghiệm của một mô hình ngôn ngữ lớn, và mô hình sẽ phản hồi bằng văn bản.

Dưới bề mặt, văn bản bạn nhập (user query) và phản hồi của mô hình được chia thành các đơn vị nhỏ gọi là tokens. Chuỗi văn bản thực chất là một chuỗi tokens một chiều. Bạn có thể quan sát các tokens này bằng các công cụ như Tiktokenizer. Một truy vấn ngắn có thể tương ứng với mười mấy tokens, và phản hồi cũng tương tự.

Trong một cuộc hội thoại, không chỉ có nội dung văn bản mà còn có các metadata để duy trì ngữ cảnh. Dưới lớp giao diện “bong bóng chat” quen thuộc, hệ thống sẽ thêm vào các tokens đặc biệt để đánh dấu sự bắt đầu và kết thúc của tin nhắn từ người dùng và trợ lý ảo. Toàn bộ cuộc trò chuyện, bao gồm cả truy vấn và phản hồi, được xây dựng thành một chuỗi tokens một chiều. Khi bạn bắt đầu một cuộc trò chuyện mới, cửa sổ tokens (context window) sẽ được làm mới, đưa số lượng tokens trở về không.

Cấu trúc và Kiến thức của Mô hình Ngôn ngữ

Khi bạn tương tác với một LLM, bạn đang “nói chuyện” với một thực thể khép kín. Hãy hình dung nó như một tệp zip khổng lồ (khoảng 1 terabyte) chứa hàng nghìn tỷ tham số của một mạng nơ-ron. Mục tiêu của mạng nơ-ron này là dự đoán token tiếp theo trong một chuỗi dựa trên dữ liệu internet khổng lồ mà nó đã được huấn luyện. Quá trình pre-training này rất tốn kém (hàng chục triệu đô la) và do đó không được thực hiện thường xuyên. Điều này dẫn đến việc các mô hình có “knowledge cut-off”, nghĩa là kiến thức của chúng chỉ giới hạn đến thời điểm trước khi quá trình pre-training cuối cùng kết thúc.

Sau giai đoạn pre-training, mô hình trải qua giai đoạn post-training, nơi nó được huấn luyện trên dữ liệu hội thoại do con người tạo ra. Giai đoạn này giúp mô hình tiếp thu “tính cách” của một trợ lý ảo, có khả năng trả lời câu hỏi và tương tác theo phong cách trò chuyện. Vì vậy, LLM kết hợp kiến thức từ internet (pre-training) với phong cách tương tác của trợ lý ảo (post-training).

Điều quan trọng cần nhớ là mô hình ngôn ngữ không có sẵn các công cụ bên ngoài như máy tính, trình thông dịch Python hay trình duyệt web theo mặc định. Nó chỉ là một “tệp zip” phản hồi tokens dựa trên kiến thức và phong cách đã được huấn luyện.

Sử dụng Mô hình Ngôn ngữ cho các Tác vụ Thực tế

Bạn có thể đặt cho ChatGPT những câu hỏi dựa trên kiến thức mà nó có thể đã thu thập được trong quá trình pre-training, đặc biệt là những thông tin phổ biến và không thay đổi nhiều theo thời gian. Tuy nhiên, bạn không được đảm bảo rằng câu trả lời luôn chính xác, vì đó chỉ là sự “ghi nhớ” xác suất từ internet. Bạn nên kiểm tra lại thông tin từ các nguồn chính thống.

Khi tương tác, hãy lưu ý đến độ dài của cuộc trò chuyện. Khi chuyển sang một chủ đề mới, nên bắt đầu một cuộc trò chuyện mới để làm mới cửa sổ tokens. Việc duy trì một cửa sổ tokens quá dài có thể làm mô hình bị “distracted” và làm giảm độ chính xác cũng như tăng chi phí và thời gian xử lý.

Bạn cũng cần chú ý đến mô hình bạn đang sử dụng. Các mô hình lớn hơn thường mạnh mẽ hơn nhưng cũng tốn kém hơn để tính toán. ChatGPT cung cấp các gói dịch vụ khác nhau (Free, Plus, Pro) với quyền truy cập vào các mô hình khác nhau (ví dụ: GPT-4o, GPT-4o mini) với các giới hạn sử dụng khác nhau. Các nhà cung cấp LLM khác như Anthropic (Claude), Google (Gemini) cũng có các mô hình và gói dịch vụ tương tự. Hãy cân nhắc lựa chọn mô hình phù hợp với nhu cầu và ngân sách của bạn.

Mô hình “Tư duy” và Reinforcement Learning

Gần đây, một bước tiến quan trọng trong huấn luyện LLMs là việc tích hợp reinforcement learning để khuyến khích khả năng suy luận. Các mô hình được huấn luyện theo cách này có thể thực hiện nhiều bước “suy nghĩ” hơn trước khi đưa ra câu trả lời. Điều này đặc biệt hữu ích cho các vấn đề phức tạp như toán học, lập trình và những tác vụ đòi hỏi nhiều tư duy. Tuy nhiên, quá trình “suy nghĩ” này có thể tốn nhiều thời gian hơn. Một số nền tảng như Grok cho phép người dùng bật/tắt chế độ “suy nghĩ”.

Sử dụng Công cụ: Tìm kiếm Internet

Để vượt qua giới hạn “knowledge cut-off”, LLMs có thể được trang bị khả năng sử dụng các công cụ, một trong những công cụ hữu ích nhất là tìm kiếm internet. Khi mô hình cần thông tin mới, nó có thể tự động đưa ra truy vấn tìm kiếm, truy cập các trang web, trích xuất nội dung và đưa thông tin đó vào cửa sổ ngữ cảnh để trả lời câu hỏi của bạn. Điều này giúp mô hình trả lời các câu hỏi về những sự kiện gần đây mà nó chưa được huấn luyện.

Các nền tảng khác nhau có mức độ tích hợp công cụ tìm kiếm khác nhau. Perplexity AI là một ví dụ về LLM tập trung vào tìm kiếm internet. ChatGPT cũng đã tích hợp tính năng “Search the web”. Một số mô hình có thể tự động phát hiện khi nào cần tìm kiếm, trong khi những mô hình khác có thể yêu cầu bạn kích hoạt tính năng này. Claude (tính đến tháng 4/2024) chưa tích hợp công cụ tìm kiếm, trong khi Gemini có những phiên bản hỗ trợ tìm kiếm và những phiên bản không.

Tính năng tìm kiếm internet rất hữu ích cho các truy vấn về thông tin mới nhất, những sự kiện hiện tại hoặc những thông tin có thể thay đổi theo thời gian. Bạn nên kiểm tra nguồn trích dẫn mà mô hình cung cấp để đảm bảo tính chính xác của thông tin.

Nghiên cứu Sâu (Deep Research)

Deep Research là một tính năng nâng cao, kết hợp khả năng tìm kiếm internet và “tư duy” sâu trong một khoảng thời gian dài (hàng chục phút). Tính năng này cho phép mô hình thực hiện nhiều truy vấn tìm kiếm, phân tích lượng lớn tài liệu (ví dụ: các bài báo khoa học) và tổng hợp thành một báo cáo chi tiết. ChatGPT Pro (gói $200/tháng) là một trong những nền tảng đầu tiên cung cấp tính năng này. Perplexity (với “Deep Research”) và Grok (với “Deep Search”) cũng có các tính năng tương tự.

Deep Research rất hữu ích để tìm hiểu sâu về một chủ đề phức tạp, nhận được các trích dẫn và tổng hợp thông tin từ nhiều nguồn. Tuy nhiên, bạn vẫn cần thận trọng với khả năng “hallucination” của mô hình và nên kiểm tra lại các nguồn. Tính năng này có thể được sử dụng để so sánh sản phẩm, nghiên cứu các tiến bộ khoa học, v.v..

Tải lên và Xử lý Tài liệu

Bạn có thể tải lên các tài liệu (ví dụ: PDF, text) để mô hình tham khảo trong cửa sổ ngữ cảnh. Điều này cho phép bạn đặt câu hỏi cụ thể về nội dung của tài liệu. Các LLMs thường chuyển đổi tài liệu thành văn bản để xử lý. Tính năng này rất hữu ích để tóm tắt tài liệu, đọc sách cùng với LLM để tăng cường sự hiểu biết và khả năng ghi nhớ, đặc biệt là với các tài liệu chuyên ngành hoặc văn bản cổ. Hiện tại, việc này thường đòi hỏi thao tác sao chép và dán thủ công.

Sử dụng Trình thông dịch Python và Phân tích Dữ liệu Nâng cao

Một công cụ mạnh mẽ khác là khả năng sử dụng trình thông dịch Python, cho phép LLM viết và chạy các chương trình máy tính để giải quyết các vấn đề phức tạp. Khi gặp các phép toán phức tạp, ChatGPT có thể tự động sử dụng trình thông dịch Python để tính toán kết quả. Tuy nhiên, không phải tất cả các LLMs đều có quyền truy cập vào trình thông dịch Python.

Phân tích Dữ liệu Nâng cao (Advanced Data Analysis), hiện tại là tính năng độc đáo của ChatGPT, cho phép bạn tải lên dữ liệu (ví dụ: bảng tính) và yêu cầu ChatGPT thực hiện phân tích, vẽ biểu đồ, tìm xu hướng. ChatGPT sẽ viết và chạy mã Python để thực hiện các tác vụ này. Mặc dù rất mạnh mẽ, bạn cần cẩn thận kiểm tra mã và kết quả vì mô hình có thể đưa ra các giả định ngầm hoặc thậm chí “hallucinate” thông tin.

Tạo Ứng dụng Tùy chỉnh với Artifacts (Claude)

Artifacts là một tính năng của Claude, cho phép nó viết mã cho các ứng dụng web nhỏ (ví dụ: sử dụng React) dựa trên yêu cầu của bạn và chạy trực tiếp trong trình duyệt. Ví dụ, bạn có thể yêu cầu Claude tạo một ứng dụng flashcards từ một đoạn văn bản. Đây là một mô hình khác biệt so với việc sử dụng các ứng dụng có sẵn, vì Claude tạo ra ứng dụng tùy chỉnh chỉ dành cho bạn. Các ứng dụng này chạy cục bộ trong trình duyệt và có thể khá hữu ích cho các tác vụ cụ thể. Một ứng dụng hữu ích khác của Artifacts là tạo sơ đồ khái niệm từ văn bản bằng cách sử dụng thư viện Mermaid.

Lập trình với LLMs: Từ Trình duyệt đến Các Ứng dụng Chuyên dụng

Mặc dù LLMs có khả năng viết mã trong trình duyệt, nhưng đối với công việc lập trình chuyên nghiệp, việc sử dụng các ứng dụng chuyên dụng như Cursor (sử dụng Claude 3.7) mang lại hiệu quả cao hơn. Các ứng dụng này có quyền truy cập vào hệ thống tệp của bạn, cho phép chúng hiểu toàn bộ ngữ cảnh của dự án. Các tính năng như “Composer” trong Cursor có thể hoạt động như một “autonomous agent” trên codebase của bạn, thực hiện các lệnh phức tạp và chỉnh sửa nhiều tệp. Phương pháp lập trình này đôi khi được gọi là “vibe coding”, nơi bạn giao quyền kiểm soát cho LLM và chỉ định những gì cần làm. Bạn vẫn có thể quay lại lập trình truyền thống nếu cần gỡ lỗi hoặc tùy chỉnh sâu hơn.

Tương tác Đa phương tiện: Âm thanh

Bạn có thể tương tác với LLMs bằng giọng nói. Có hai chế độ chính:

- Chuyển giọng nói thành văn bản: Ứng dụng sẽ nghe giọng nói của bạn và chuyển đổi nó thành văn bản để gửi đến mô hình. Trên điện thoại di động, việc này thường rất dễ dàng thông qua biểu tượng micro. Trên máy tính để bàn, bạn có thể sử dụng các ứng dụng của bên thứ ba như Super Whisper để chuyển giọng nói thành văn bản trong bất kỳ ứng dụng nào.

- Chuyển văn bản thành giọng nói: Ứng dụng sẽ đọc to phản hồi của mô hình. Nhiều ứng dụng như ChatGPT có biểu tượng “Read aloud” cho phép bạn sử dụng tính năng này.

Gần đây, đã xuất hiện công nghệ xử lý âm thanh trực tiếp trong mô hình ngôn ngữ (“true audio” hoặc “advanced voice mode”). Thay vì chuyển đổi giữa âm thanh và văn bản, mô hình có thể hiểu và tạo ra các tokens âm thanh trực tiếp. Tính năng “Advanced voice mode” của ChatGPT (có thể đã được mở rộng cho người dùng miễn phí) là một ví dụ. Nó cho phép bạn trò chuyện tự nhiên bằng giọng nói, và mô hình có thể phản hồi bằng nhiều giọng điệu khác nhau (ví dụ: giọng Yoda, giọng cướp biển). Grok cũng cung cấp tính năng tương tự trên ứng dụng di động. Tuy nhiên, tính năng “advanced voice” đôi khi có thể hoạt động không ổn định.

NotebookLM của Google cung cấp một cách độc đáo để tương tác với thông tin thông qua âm thanh: nó có thể tạo podcast tùy chỉnh từ các nguồn bạn cung cấp (ví dụ: PDF, trang web). Bạn có thể nghe podcast này và thậm chí tương tác bằng cách đặt câu hỏi.

Tương tác Đa phương tiện: Hình ảnh và Video

Tương tự như âm thanh, hình ảnh có thể được biểu diễn dưới dạng tokens, cho phép LLMs xử lý và hiểu nội dung hình ảnh. Bạn có thể tải lên hình ảnh trong các ứng dụng LLM và đặt câu hỏi về chúng. Ví dụ, bạn có thể tải lên nhãn dinh dưỡng của một sản phẩm để biết thêm thông tin về các thành phần, hoặc kết quả xét nghiệm máu để được giải thích. Việc chụp ảnh màn hình và dán vào ứng dụng cũng là một cách tiện lợi để tương tác với nội dung trực quan. Bạn nên kiểm tra kỹ phần phiên âm của mô hình để đảm bảo nó hiểu đúng nội dung hình ảnh.

LLMs cũng có khả năng tạo ra hình ảnh dựa trên mô tả văn bản thông qua các mô hình như DALL-E của OpenAI. Bạn có thể yêu cầu tạo hình ảnh với nhiều phong cách và chủ đề khác nhau. Tính năng này thường được sử dụng cho việc tạo nội dung sáng tạo như biểu tượng hoặc hình ảnh minh họa. Hiện tại, việc tạo ảnh thường được thực hiện bởi một mô hình riêng biệt nhận mô tả văn bản từ LLM.

Một số LLMs trên ứng dụng di động (ví dụ: ChatGPT với “advanced voice”) còn có khả năng “nhìn” video thông qua camera của thiết bị. Bạn có thể hướng camera vào các đối tượng và đặt câu hỏi về chúng. Mặc dù có vẻ như xử lý video trực tiếp, nhưng có thể hệ thống vẫn đang dựa trên việc phân tích các khung hình riêng lẻ.

Công nghệ tạo video từ văn bản cũng đang phát triển rất nhanh chóng, với nhiều mô hình AI có khả năng tạo ra các video ấn tượng.

Các Tính năng Nâng cao và Tiện ích

Nhiều LLMs cung cấp các tính năng nâng cao để cải thiện trải nghiệm người dùng:

- Bộ nhớ (Memory): ChatGPT có khả năng ghi nhớ thông tin từ các cuộc trò chuyện trước đó. Đôi khi nó sẽ tự động cập nhật bộ nhớ, hoặc bạn có thể yêu cầu nó nhớ một thông tin cụ thể. Bộ nhớ này được sử dụng để cung cấp ngữ cảnh cho các cuộc trò chuyện tiếp theo, giúp mô hình hiểu bạn hơn theo thời gian. Bạn có thể quản lý và chỉnh sửa bộ nhớ này.

- Hướng dẫn Tùy chỉnh (Custom Instructions): Bạn có thể điều chỉnh cách ChatGPT phản hồi bằng cách cung cấp các hướng dẫn tùy chỉnh về tính cách, phong cách giao tiếp, hoặc các yêu cầu cụ thể khác. Điều này có thể được thiết lập trong phần cài đặt.

- GPTs Tùy chỉnh (Custom GPTs): ChatGPT cho phép bạn tạo ra các phiên bản tùy chỉnh của mô hình cho các mục đích cụ thể. Bạn có thể thiết lập hướng dẫn, cung cấp dữ liệu và định nghĩa các hành động cho GPT tùy chỉnh. Ví dụ, bạn có thể tạo GPTs để trích xuất từ vựng từ văn bản học ngoại ngữ, dịch thuật chi tiết, hoặc xử lý hình ảnh có chữ (ví dụ: OCR và dịch). Tính năng này giúp bạn tiết kiệm thời gian nhập prompt lặp đi lặp lại. Các nền tảng LLM khác có thể có các tính năng tương tự.

Tóm lại, hệ sinh thái LLM đang phát triển rất nhanh chóng với nhiều tính năng và ứng dụng đa dạng. ChatGPT là một lựa chọn tốt với nhiều tính năng phong phú, nhưng các nền tảng khác cũng có những ưu điểm riêng. Khi lựa chọn và sử dụng LLMs, hãy cân nhắc các yếu tố như mô hình đang sử dụng, khả năng suy luận, quyền truy cập vào các công cụ (tìm kiếm, trình thông dịch), khả năng xử lý đa phương tiện và các tính năng tiện ích.

Biên tập từ Youtube của Andrej Karpathy

0 Lời bình